Vía El Economista

Los daños potenciales del uso de sistemas de inteligencia artificial son el control de los datos; la falta de fiabilidad y de transparencia; así como amenazas a la economía, la justicia y las libertades humanas, de acuerdo con un estudio académico.

De acuerdo con una investigación titulada The Ethics of AI Value Chains (La ética de las cadenas de valor de la IA), elaborada por Blair Attard-Frost, de la Universidad de Toronto, y David Gray Widder, de la Universidad Carnegie Mellon, las cadenas de valor son un concepto que puede ayudar a la futura investigación y a la gobernanza de la inteligencia artificial.

¿Qué son las cadenas de valor de la Inteligencia Artificial?

Los investigadores rastrean la definición de cadenas de valor hasta el modelo de cadena de valor de Michael E. Porter, un marco de administración de empresas que establece las actividades primarias y de apoyo dentro de una organización empresarial.

El concepto de cadenas de valor se ha ido expandiendo para abarcar a relaciones económicas más complejas, como puede ser el comercio internacional, y también se ha profundizado para observar relaciones de poder, laborales, espaciales, temporales y organizacionales.

Las cadenas de valor de la Inteligencia Artificial son las cadenas de valor implicadas en el desarrollo, uso y gobernanza de los sistemas de Inteligencia Artificial. Sin embargo, buena parte de la investigación alrededor de las cadenas de valor de la IA proviene de perspectivas de gestión estratégica o de la ingeniería industrial.

“Las cadenas de valor pueden servir como puentes teóricos y analíticos entre muchos actores, actividades y contextos, lo que permite a los investigadores y profesionales dar mejor cuenta de la amplia gama de preocupaciones éticas implicadas en el desarrollo, uso y gobernanza de los sistemas de IA”, escriben Attard-Frost y Gray en el artículo.

¿Cuáles son los problemas éticos de la Inteligencia Artificial?

El artículo relaciona las cadenas de valor de la IA con los problemas éticos identificados por Bernd Carsten Stahl en su libro Artificial Intelligence for a Better Future. La tipología de Stahl identifica seis tipos de beneficios frente a ocho tipos y 30 subtipos de daños potenciales ocasionados por el uso de la inteligencia artificial.

Entre los beneficios, Stahl enlista la obtención de nuevas perspectivas a partir de los datos; mejora de la eficiencia; beneficios económicos y medioambientales y la contribución a los objetivos de desarrollo sostenible de la ONU.

En contraparte, los daños potenciales del uso de sistemas de inteligencia artificial son el control de los datos; la falta de fiabilidad y de transparencia; así como amenazas a la economía, la justicia y las libertades humanas, entre otros.

Lo revelador del artículo de Attard-Frost y Gray es la diversidad de actores involucrados en la cadena de valor de la AI que tendrían incidencia en problemas como la transparencia y la fiabilidad de los resultados de esta tecnología: propietarios de los datos, desarrolladores de modelos (de IA), usuarios de aplicaciones, gobiernos, tribunales y organismos reguladores, financiación de la investigación, fuentes y beneficiarios.

Incidentes relacionados con la Inteligencia Artificial

Los investigadores acuden también a ejemplos empíricos acerca de estos problemas éticos, los cuales obtienen gracias a la AI Incident Database, una plataforma que recopila aquellos incidentes ocurridos al utilizar sistemas de inteligencia artificial.

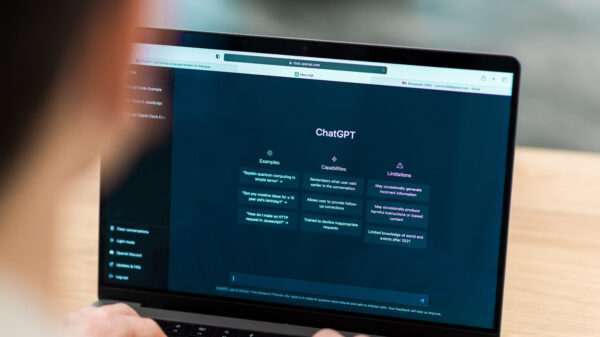

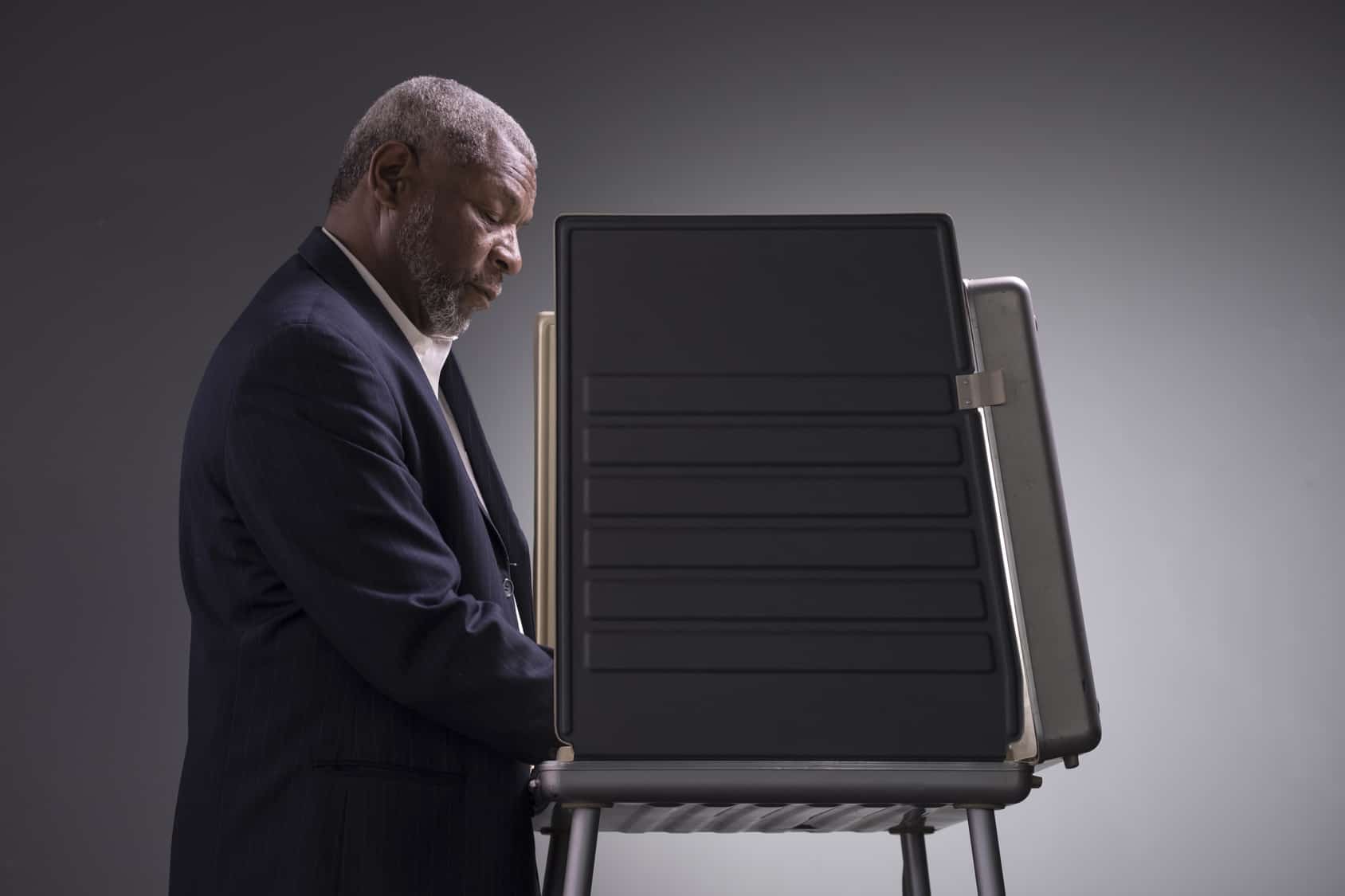

Entre los incidentes registrados en esta plataforma se encuentran el uso de reconocimiento facial por parte de la Policía de Miami durante el arresto de manifestantes durante una protesta a propósito del asesinato de George Floyd; el uso del modelo generativo de lenguaje ChatGPT para la revisión de solicitudes de becas, o el choque de un vehículo Tesla contra un camión detenido mientras se encontraba en modo de conducción autónoma.

Las organizaciones con un mayor número de incidentes registrados incluyen sobre todo a grandes empresas tecnológicas (big tech), como Meta, Tesla, Google, OpenAI y Amazon.

Recomendaciones

A partir de su análisis, los autores del estudio proponen un enfoque integral para intervenir en la ética de las cadenas de valor de la inteligencia artificial. Es decir, abordar tanto aquellas preocupaciones éticas relacionadas con el desarrollo técnico de la inteligencia artificial, por ejemplo, la recopilación de datos de entrenamiento, como aquellas que se dan en otras partes de la cadena de valor de la IA, como el uso de reconocimiento facial por parte de los gobiernos.

Los investigadores proponen llevar a cabo más investigación empírica y de acción sobre las preocupaciones éticas específicas, los actores de la cadena de valor y las actividades de dotación de recursos; desarrollar, aplicar y evaluar la eficacia de los métodos para modelar sistemáticamente las cadenas de valor de la IA; identificar los problemas en esas cadenas de valor y planificar y ejecutar intervenciones en las mismas; diseñar y aplicar prácticas de abastecimiento éticas en todas las cadenas de valor que intervienen en el aprovisionamiento de los sistemas de IA y diseñar y aplicar leyes, reglamentos y otros instrumentos políticos destinados a distribuir equitativamente los beneficios y las responsabilidades en la prevención de daños a lo largo de las cadenas de valor de la IA.